人工智能在图像生成领域实现了令人瞩目的突破。从早期的风格迁移到如今的文生图(Text-to-Image)模型,AI正以前所未有的速度改变着艺术创作与视觉表达的范式。其中,ControlNet的出现,标志着AI在图像生成控制能力上的飞跃,实现了对深度、边缘等信息的精准复用,堪称对传统绘画方式的“降维打击”。

一、从文生图到精准控制:ControlNet的革新意义

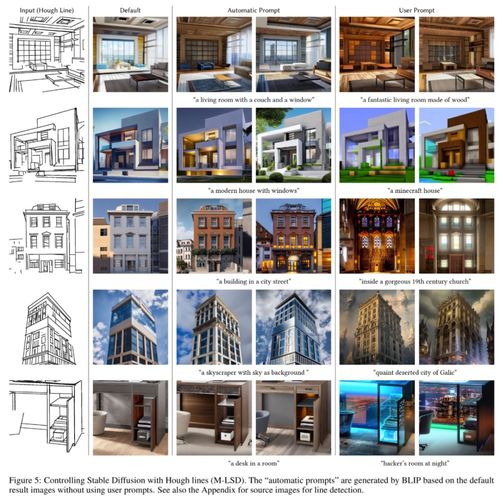

传统的文生图模型,如Stable Diffusion、DALL·E等,能够根据文本提示生成丰富多样的图像,但其生成过程往往具有较高的随机性,用户难以精确控制构图、姿态、细节等要素。这导致生成结果虽然创意十足,但在需要特定结构或风格的场景中,常常无法满足精准需求。

ControlNet的引入,正是为了解决这一核心问题。它通过将额外的条件信息(如边缘图、深度图、人体姿态关键点等)作为控制信号,注入到预训练的扩散模型中,从而实现对生成过程的“细粒度引导”。这意味着,艺术家或设计师可以先用简单的线稿、深度估计图或姿态草图来定义图像的基本结构,再通过文本描述填充风格、材质和内容,最终生成既符合预设结构又富有创意的作品。

二、深度与边缘:信息复用的双重引擎

ControlNet的核心优势在于其对多种信息类型的支持,其中深度(Depth)和边缘(Canny Edge)信息尤为重要。

- 深度信息控制:通过输入一张深度估计图(标识场景中物体的远近关系),ControlNet能够引导生成模型在正确的三维空间关系中布置物体。例如,在建筑可视化中,设计师可以先提供场景的深度信息,再描述“现代风格客厅,午后阳光”,AI便能生成透视准确、空间感强烈的室内效果图,大大提升了设计效率。

- 边缘信息控制:边缘图(如Canny边缘检测结果)保留了原始图像的结构轮廓。艺术家可以手绘或提取一张线稿,作为生成图像的“骨架”。结合文本提示,AI能够在线稿的基础上渲染出逼真或风格化的完整图像。这种方式不仅降低了绘画门槛,也让专业画家能够快速将构思转化为草稿,再借助AI完善细节,实现人机协同创作。

三、图灵信息的全能复用:迈向通用视觉智能

ControlNet所处理的深度、边缘、姿态等信息,本质上是视觉场景的抽象表示,可视为一种“图灵信息”——即能够被计算系统识别、处理和转换的标准化信息。这种信息的复用能力,使得AI不再局限于从零生成,而是能够基于现有视觉素材进行重构、编辑和再创作。

例如,在影视后期中,可以利用ControlNet将实拍视频的每一帧转换为深度图或边缘图,再通过文本指令统一调整场景风格(如“转换为水彩动画风格”),实现高效且风格一致的特效处理。在游戏开发中,原画师的角色线稿可以直接作为输入,快速生成多种配色、材质方案,加速迭代过程。

四、人类画家的挑战与机遇

AI在控制力上的突破,确实对传统绘画行业构成了挑战。一些基础性的绘图工作(如商品插画、场景概念草图)可能逐渐被AI辅助工具取代。这并非意味着人类画家的终结,而是创作范式的演进。

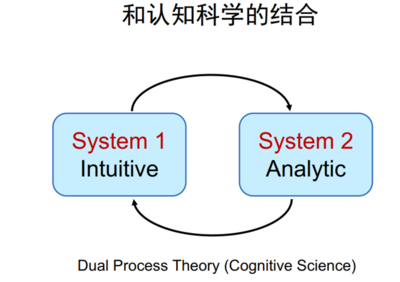

AI无法替代人类的情感和叙事能力。作品的灵魂——创意、故事性和情感表达——仍然依赖于人类的智慧。ControlNet等工具将画家从繁琐的重复劳动中解放出来,让其更专注于创意构思和艺术决策。人机协同将成为新趋势:画家提供创意、结构和审美指导,AI负责执行和细化,二者结合可能催生前所未有的艺术形式。

五、未来展望:可控生成与创造性共生

随着ControlNet技术的不断优化,未来我们可能看到更多类型的控制信息被集成,如光影分布、材质纹理、动态模糊等。这将进一步拓展AI在动画、虚拟现实、工业设计等领域的应用。伦理与版权问题也需被重视,确保技术被用于促进创新而非替代人类创造力。

ControlNet通过深度与边缘信息的复用,实现了文生图模型从“随机生成”到“精准控制”的跨越。它不仅是技术上的突破,更是人机关系的一次重新定义。在这个AI降维打击传统流程的时代,真正的赢家或许是那些能够拥抱变化,将技术转化为创造力延伸的艺术家与创作者。